来源:自学PHP网 时间:2015-04-15 10:59 作者: 阅读:次

[导读] 网站的收录比例往往是很多优化人员极其重视的一个指标之一,网站的收录好坏,从根本上能够决定网站的流量多少,毕竟有收录才会有排名,有排名才可能会有流量。但是网站收录是...

|

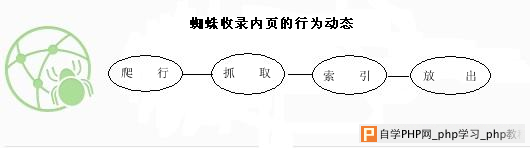

网站的收录比例往往是很多优化人员极其重视的一个指标之一,网站的收录好坏,从根本上能够决定网站的流量多少,毕竟有收录才会有排名,有排名才可能会有流量。但是网站收录是一个困扰许多站长的难题,很多站长拼命努力做站,却发现蜘蛛并不青睐自己的网站,收录数量也寥寥无几。 当站长们苦恼网站为何不被收录时,应该去想想,究竟是谁在决定网站的收录?答案很明显,就是搜索引擎蜘蛛。既然搜索引擎蜘蛛是收录的决定者,我们就应该从蜘蛛的工作原理入手,深入去研究一下,然后抓住蜘蛛工作原理规律去制定方案对策,来实现网站的收录最大化。好了,废话不多说,下面笔者就来简单和大家讨论一下吧。

原理一:通过网站链接爬行网站内页 搜索引擎机器人之所以被称之为蜘蛛,原因就是其行为极其类似蜘蛛。蜘蛛会通过网站上的网状链接来爬行一个网站的页面,如果一个网站没有任何链接入口,那么蜘蛛将会无从下手。因此,要实现网站收录最大化,第一步工作就是要为蜘蛛提供更多的、更加紧密链接入口。最简单的方法就是为蜘蛛制造更多内部链接,比如笔者的一个网站就是如此,笔者在每次编辑完文章后都会添加一到两条“阅读推荐”的链接,为蜘蛛提供一个爬行入口,如下图:

原理二:根据网站结构情况来抓取内页 当蜘蛛寻找到一个爬行入口后,它就会开始进行下一步工作——抓取页面内容。但是要注意的是,蜘蛛是不可能一次性把网站上的内容都抓取的,它是会根据网站结构情况去抓取,也就是说,如果网站的结构不合理,将会成为蜘蛛抓取页面的一个绊脚石。因此,站长们应该从两个方面去解决网站内部结构问题: (1)精简flash以及js代码。百度也曾经声明过,蜘蛛对于含有过量flash元素的网站是比较难以抓取的,因此站长们应该尽量不在网站上使用flash,即使要用也要选取容量较小的flash;对于js代码也是如此,过于华丽的js功能其实是不必要的,这只会加重蜘蛛的抓取压力,因此,把冗余的js去掉或者合并是一个明智的选择。 (2)彻底清除网站死链接。网站死链接的产生有时是不可避免的,但是如果不及时注意清理,也会成为蜘蛛抓取页面的一个绊脚石。站长们千万不要嫌麻烦,最好养成每天一查的好习惯,只要一发现死链接,就应该到ftp删除之,又或者到百度站长平台上提交死链接,告诉蜘蛛这是一个死链接,不要再去爬行,这样才能让蜘蛛增加对你的网站好感度。 原理三:根据内容质量来尝试索引页面 网站的结构如果没有什么大问题的话,蜘蛛一般都能够顺利抓取页面,然后进行下一步的工作——索引页面内容。这一步工作是重中之重,如果成功索引,那么你的网站页面内容也就算成功被收录了,而蜘蛛索引页面的决定性因素就是页面的内容质量。如果一个网站的页面内容过关,或者内容重复度过高都会被蜘蛛轻易否决。所以,为了让蜘蛛成功索引我们的页面,站长们应该要着重网站的内容建设,做到规律更新,即使无法原创也要做到深度伪原创,尽量为蜘蛛提供新鲜的内容。当然我们也可以通过站长工具或者蜘蛛日志来观察蜘蛛对我们的网站索引情况:

原理四:考察过后再发出内页 当蜘蛛完成上面三步工作,并成功索引页面后,那么就可以说我们的页面内容被真正收录了,但是你也不要兴奋过早,因为收录并不等于页面被放出了。蜘蛛有一个工作原理,就是索引后不会立刻放出页面内容,而是会选择性地考察一下才会放出,这段时期我们不必过分紧张,只要继续做好内容更新,耐心等待,不要犯什么大错误,我们的页面内容很快就可以放出了! 蜘蛛只是一个用代码编写的程序机器人,它的规律始终是被人掌握在手上的,因此我们网站收录不理想的时候应该多去研究一下蜘蛛的工作原理,并自己总结出一些规律来制定方案来解决收录问题,这样我们的网站才能实现收录最大化。本文专为北京大学人民医院网上挂号http://www.bjrmyyghw.com供稿,希望转载的朋友加上一条链接,谢谢大家支持 |

自学PHP网专注网站建设学习,PHP程序学习,平面设计学习,以及操作系统学习

京ICP备14009008号-1@版权所有www.zixuephp.com

网站声明:本站所有视频,教程都由网友上传,站长收集和分享给大家学习使用,如由牵扯版权问题请联系站长邮箱904561283@qq.com